요약 비교

| MLP | Fully Connected | 단순한 구조 | 일반 분류/회귀 |

| CNN | Convolutional | 이미지에 강함 | 이미지 처리, 영상 인식 |

| RNN | 순환 연결 | 시계열 처리 | 텍스트, 음성, 시계열 |

| LSTM/GRU | RNN 확장형 | 긴 의존성 처리 | 자연어 처리, 번역 |

| Autoencoder | 인코더/디코더 | 특징 압축 및 복원 | 이상 탐지, 노이즈 제거 |

| GAN | 생성자/판별자 | 고품질 데이터 생성 | 이미지 생성, 예술 작품 |

| Transformer | Self-Attention | 병렬 처리, 장기 의존성 | NLP, 생성형 AI, 번역 등 |

RNN

사용 예시

자연어 처리

- 문장 감정 분석

- 기계 번역 (영어 -> 한국어)

- 텍스트 생성 (자동 문장 생성)

- 챗봇 응답 생성

음성 처리

- 음성을 텍스트로 변환, TTS

비디오/모션 분석

- 행동 인식

- 비디오 자막 생성

동작 순서

입력, 은닉 상태, 출력

STEP t :

- 입력 xt + 이전 은닉 상태 ht-1 + 새로운 은닉 상태 ht -> 출력 yt

- 은닉 상태 계산 : ht = tanh(Wxh * xt + Whh * ht-1 + bh)

- yt = Why*ht + by

✨ 핵심 요약

| 입력 데이터 | 시간 순서대로 들어오는 벡터들 (예: 단어 임베딩, 센서 데이터) |

| 은닉 상태 | 이전 정보를 기억하는 내부 메모리 (hₜ) |

| 파라미터 공유 | 시간축을 따라 같은 RNN 셀이 반복되며 학습 파라미터도 공유됨 |

| 문제점 | 장기 의존성(긴 문맥) 처리 어려움 → LSTM/GRU로 개선됨 |

LSTM

사용예시

RNN과기본적으로 유사한데,

시계열 예측

- 주가 예측, 날씨 예측, 센서 기반 예지보전

비디오/행동 인식

- 프레임 간 시간 흐름 이해

- 자율주행 행동 판단

동작 순서

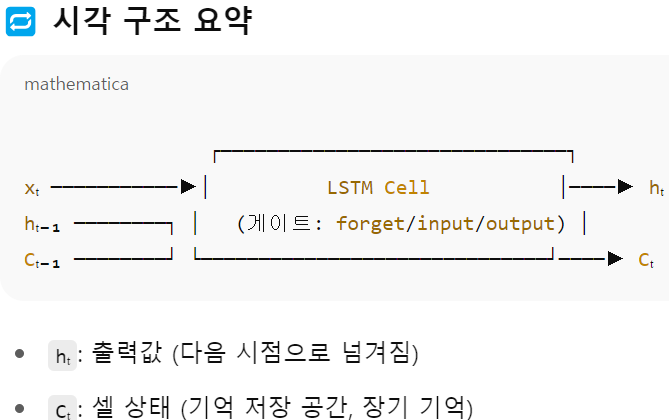

LSTM은 기본 RNN 구조에 3개의 게이트와 셀 상태를 추가하여, 기억 유지와 삭제를 제어합니다.

- 셀 상태 (Ct) - 오래 기억되는 정보 (장기 기억 저장소)

- 은닉상태 (ht) - 현재 출력과 다음 step에 전달될 정보

- 3개의 게이트와 하나의 동작에 대한 설명

- forget gate 어떤 기억을 지울지 결정 ft = σ(W_f * [ht-1, xt] + b_f)

- input gate 어떤 새로운 정보를 저장할지 결정 it = σ(W_i *[ht-1, xi] + b_i), C~t = tanh(W_C*[ht-1, xt] + b_C)

- 셀 상태 업데이트 Ct = ft * Ct-1 + it * C~t

- output gate 최종 출력을 결정 ot = σ(W_o*[ht-1, xt] + b_o), ht = ot*tanh(Ct)

'자격증' 카테고리의 다른 글

| GAN, Transformer (0) | 2025.06.22 |

|---|---|

| MLP, Autoencoder (3) | 2025.06.15 |

| CNN (0) | 2025.06.15 |

| [ADsP] 빅데이터 분석방법론 (1) | 2025.01.26 |